Superinteligencia y riesgo existencial

ConceptoSobre

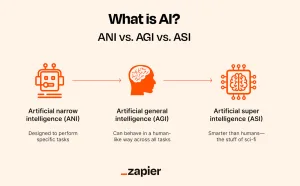

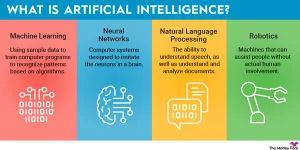

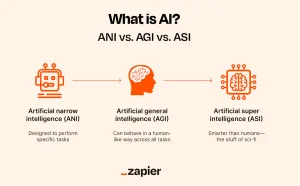

La superinteligencia se refiere a una entidad hipotética que posee una inteligencia muy superior a la de las mentes humanas más brillantes. A menudo se asocia con sistemas de inteligencia artificial (IA) que podrían superar a los humanos en una amplia gama de tareas cognitivas. El concepto de superinteligencia genera preocupación por los posibles riesgos y beneficios que podría traer. Por un lado, podría conducir a avances significativos en diversos campos, como la medicina y la tecnología. Por otro lado, existe el temor de que dicha inteligencia se vuelva incontrolable y represente un riesgo existencial para la humanidad. El riesgo existencial de la superinteligencia es un tema de intenso debate. Se centra en la posibilidad de que los sistemas avanzados de IA se desalineen con los valores humanos, lo que podría provocar consecuencias catastróficas. Entre las preocupaciones se encuentra la posibilidad de una "explosión de inteligencia", en la que la IA se mejore recursivamente, volviéndose cada vez más poderosa y difícil de controlar. Este escenario pone de relieve la necesidad de una planificación y una regulación cuidadosas para garantizar que cualquier desarrollo futuro de la superinteligencia se alinee con los intereses y valores humanos. Para abordar estos riesgos se requiere un esfuerzo global para desarrollar tecnologías de IA seguras y beneficiosas.